C’è poco da dire: Google non è un motore di ricerca; Google è il motore di ricerca. Vi capita spesso di usare Google? E non vi chiedete mai il motivo per cui alcuni risultati vengono visualizzati prima rispetto ad altri? Forse perchè alcuni link sono più attinenti che altri, oppure perchè vengono aggiornati spesso… Insomma, in parole povere, come fa Google a stabilire l’ordine di priorità dei risultati? Ma poi perchè mi faccio queste domande, quando posso cercare con Google le risposte?

Big G ci ha fornito ciò che è senza dubbio il motore di ricerca più popolare ed efficace (googlare è pure diventato un neologismo, cfr. treccani). Molti di noi danno per scontato il funzionamento e la validità dei risultati della ricerca di di Google Search, senza preoccuparsi di chiedersi cosa succede dietro le quinte e come stanno in realtà le cose. Tuttavia, se sei arrivato a leggere fin qui, vuol dire che la cosa ti interessa o forse è perchè possiedi o lavori in un campo in cui Google potrebbe aiutare il tuo business. In tal caso, bisogna fare qualche passo indietro…

Come cominciò

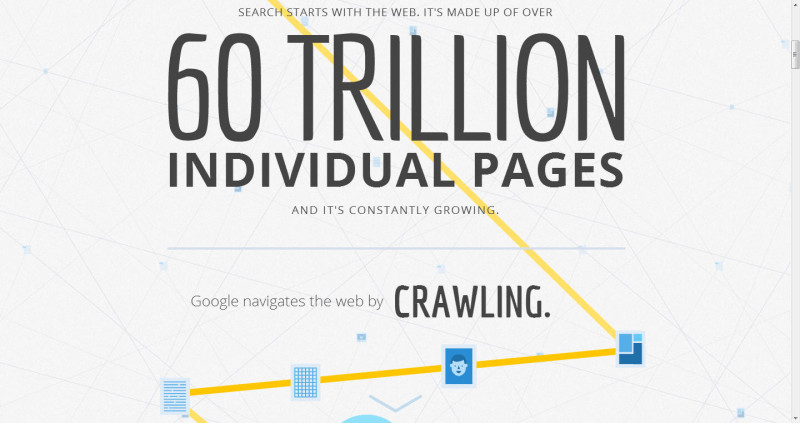

Secondo Wikipedia, Google Search è stato lanciato nel settembre 1997 da Larry Page e Sergey Brin. Tutt’oggi effettua più di tre miliardi di ricerche al giorno per gli utenti. Queste ricerche sono condotte in 60 trilioni di pagine web utilizzando un indice (un elenco di dati), la cui dimensione dovrebbe aggirarsi, secondo Google, a “soli” 95 petabyte, cioè circa 100 milioni di gigabyte!

Fase 1: Esplorazione del Web

Google fornisce una spiegazione interessante del processo di ricerca in cui afferma di usare uno speciale software (chiamato “Googlebot”) in esecuzione su un gran numero di computer con cui esegue la scansione del web, seguendo i link “da pagina a pagina”. (se vi va, pensate i tanti piccoli Minion di “Cattivissimo Me”…). Googlebot parte dal suo ultimo stato della scansione e laboriosamente cerca nuovi siti, rileva i cambiamenti dei siti esistenti e i collegamenti non validi.

Google sottolinea (ma poi chi lo sa?) di non accettare denaro per favorire o segnalare al wraler una pagina o più pagine rispetto ad altre, tuttavia i proprietari dei siti possono specificare in qualche modo il metodo di scansione dei loro siti. Ad esempio, possono impedire la visualizzazione di riassunti nei risultati di ricerca o conservare i contenuti delle pagine web nella cache dei server di Google.

Fase 2: Organizzazione dei dati

Dopo che i web crawler di Google terminano la scansione, riepilogano a Google il percorso e le pagine che hanno visitato, e quest’ultimo si occupa di aggiornare l’indice di 95 petabyte. Per mettere in chiaro, 95 petabyte è l’equivalente di 100.000 hard disk da un terabyte… questi 95.000.000.000.000.000 byte rappresenta quasi il doppio della quantità di informazioni mai scritte dall’uomo. Bazzecole. E non è nemmeno tutto quello che potenzialmente può essere indicizzato! Infatti Google afferma che “Googlebot è in grado di elaborare molti tipi di contenuto, ma non tutti. Ad esempio, non siamo in grado di elaborare il contenuto di alcuni file multimediali o delle pagine dinamiche.».

Passo 3: Presentazione dei dati

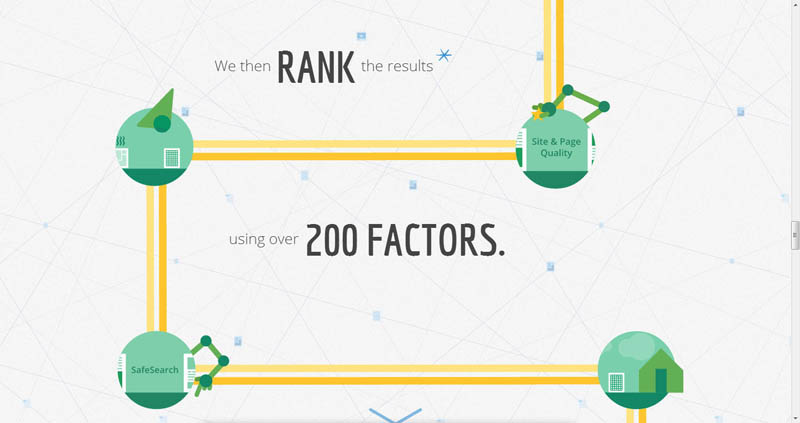

Per utilizzare una metafora, durante una ricerca, Google non si limita a buttare un’esca in questo indice e pescare il pesce più vicino, perchè in questo caso l’unica cosa che verrebbe pescata è una scarpa bucata. Vengono utilizzati invece diversi fattori per presentare i risultati di ricerca più pertinenti: ed e qui è dove avviene la “magia”. Un po’ come nella ricetta della Coca Cola, alcuni di questi ingredienti sono noti mentre altri sono tenuti riservati per contrastare coloro che potrebbero tentare di attaccare il sistema (spammer, hacker e altra feccia simile).

Quali sono i fattori noti?

- Tipo di contenuto

- Qualità del contenuto (un controllo ortografico viene utilizzato per distinguere siti professionali da aspiranti scrittori)

- Freschezza dei contenuti (siti non aggiornati dal 1996 hanno meno probabilità di essere restituiti prima dei siti del 2013)

- Nazionalità dell’utente (non ha senso restituire pagine web in un’altra lingua, a meno che non espressamente richiesto dall’utente)

- Legittimità del sito (se la pagina è stata sotto attacco, contiene dei malware o che sia legata a forme di spam)

- Nome e indirizzo del sito web

- Ricerca di sinonimi

- Promozioni sui Social network

- Quanti link puntano a una particolare pagina web

- Il valore di questi legami

Questi ultimi due punti fanno parte di un meccanismo chiamato “PageRank”. Il PageRank di ogni pagina web si basa su di un punteggio. Ai siti web vengono assegnati questi punteggi di Page Rank in base al fatto se, ad esempio, i link a tali siti web provengono da siti importanti o molto autorevoli, con un alto traffico e una struttura ben consolidata. Questi siti vengono quindi presentati più in alto nell’elenco dei risultati di ricerca, consentendo all’utente centrare al meglio la propria ricerca.

Si noti che il PageRank è abbastanza intelligente da differenziare quantità e qualità. Se un sito ha 5 collegamenti ad esso provenienti da siti di alta qualità e un altro sito ha 10 collegamenti ad esso provenienti da siti poco importanti e di bassa qualità, al primo sito verrà attribuito un PageRank più elevato.

Ad esempio, se il New York Times contenesse diversi link al mio blog, il mio blog acquisirebbe un PageRank più alto se al contrario fosse linkato in diversi siti web quasi estinti o poco autorevoli. Questo significa che se qualcuno cerca argomenti specifici e il mio blog contiene delle informazioni che corrispondono ai criteri cercati, Google è più propensa a mostrare la mia pagina nei risultati grazie a quei legami con il New York Times.

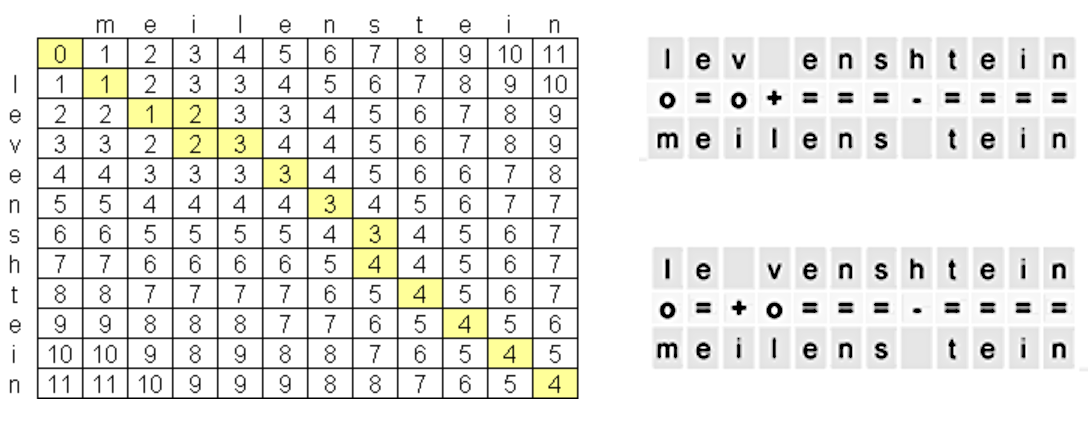

Sembra semplice, ma c’è ancora un mondo tutto da scoprire. Se ti piace il discorso e non disprezzi la matematica, la pagina di Wikipedia sul PageRank presenta un algoritmo semplificato…

Come migliorare il PageRank?

Naturalmente, ci sono stati tentativi di aumentare i punteggi di PageRank dei sito web attraverso tattiche “subdole” come Google Bombs e Link Farms. Ma collegare il vostro sito al blog dello smanettone di turno, non aiuterà più di tanto, come abbiamo visto; Un discorso parallelo si potrebbe fare con quei fantomatici servizi di auto-link e auto-follow su Facebook e Twitter.

Esistono modi legittimi per migliorare il PageRank del vostro sito web. E qui entra in gioco l’ottimizzazione dei motori di ricerca (SEO). Nei prossimi articoli, vedremo come ottimizzare al meglio le risorse a nostra disposizione per incrementare il PageRank del vostro sito.